英特尔“芯”AI,赋能云边端|第二期:用英特尔 Arc 系列显卡高效训练 YOLO 和 Qwen-7B

在 AI 驱动的 2025 年,模型训练是企业数字化转型的关键一步。然而,高昂的硬件成本和复杂的技术门槛让许多中小企业望而却步。传统 GPU(如 Nvidia H100)动辄数千美元的单价,以及高功耗带来的维护成本,成为 AI 普及的瓶颈。上海亿琪软件有限公司推出的 YiCoreAI 平台,通过英特尔 Arc 系列显卡(如 Arc A770/B580)为核心的 YiAISTUDIO 模块,提供了

openlab_96bf3613

4月前

openlab_96bf3613

4月前

英特尔“芯”AI,赋能云边端|第一期:开启 AI 新时代的云边端闭环

2025 年,人工智能(AI)正迈入新的时代。全球范围内,边缘计算的增长显著,预计 50% 以上的企业数据将在边缘设备上处理。与此同时,大型语言模型(LLM)的热潮席卷各行各业,从智能客服到数据分析,AI 的应用场景日益多元化。然而,企业和组织在拥抱 AI 转型时面临诸多挑战:高昂的硬件成本(传统 GPU 解决方案动辄 5000 美元/节点)、数据隐私风险,以及云端计算带来的延迟问题。 为了应对

openlab_96bf3613

4月前

openlab_96bf3613

4月前

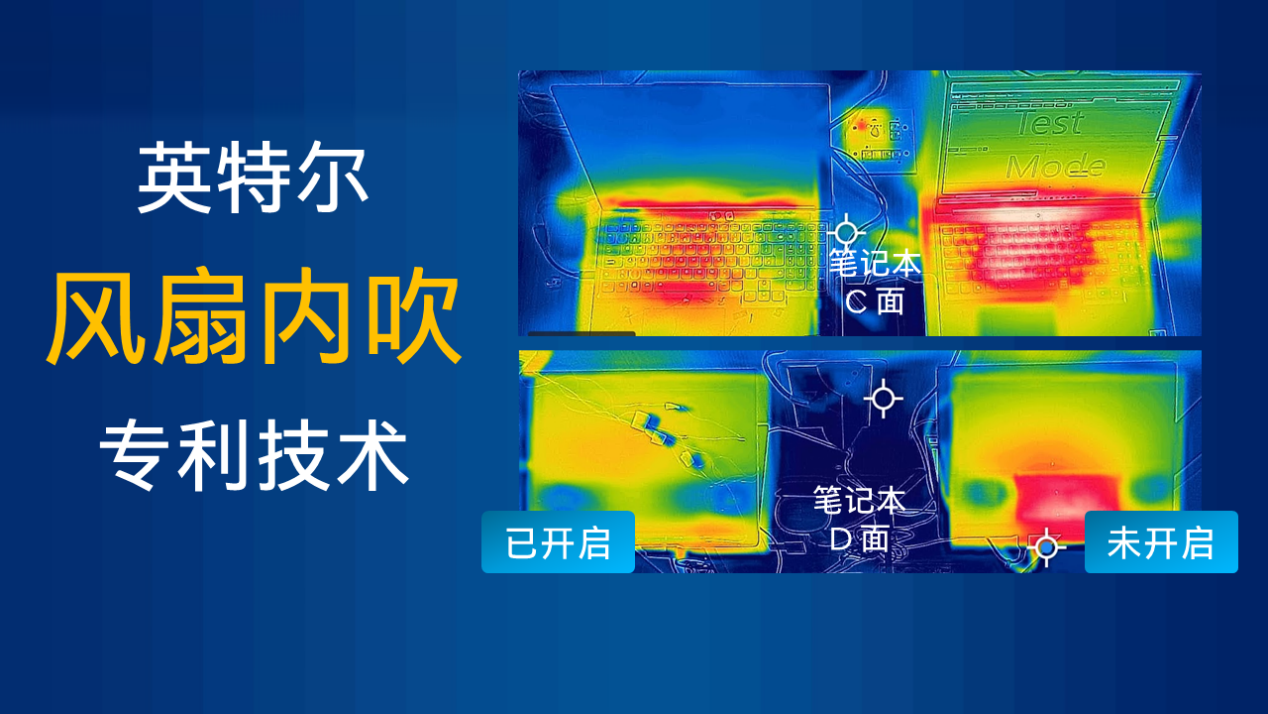

从“散热”到“灌凉风”,英特尔“内吹”风扇专利黑科技是怎么回事

游戏笔记本的 “风扇噪声”和侧面出风口的“热浪烤手”是困扰游戏玩家的两大难解之题。而近年来,越来越多的笔记本已经悄悄取消了侧面出风口,风扇噪声也日渐友好。这不仅归功于处理器高能低耗的代际提升,还得益于英特尔于2022年10月公布的风扇内吹黑科技,专利“Methods and Apparatus to Cool Electronic Devices”(内部代号:Esther Island),此项黑科

openlab_96bf3613

4月前

openlab_96bf3613

4月前

英特尔“芯”AI,赋能云边端|第三期:YiCONNECT 和 YiEDGE 实现高效管理与边缘推理

在 AI 应用日益普及的 2025 年,模型训练只是第一步,如何高效管理和分发模型,并在边缘设备上实现低延迟推理,成为企业落地的关键挑战。传统方案中,模型分发复杂、边缘推理延迟高、数据采集困难等问题阻碍了 AI 的广泛应用。上海亿琪软件有限公司的 YiCoreAI 平台 通过 YiCONNECT(管理/下发) 和 YiEDGE(推理/优化) 模块,结合英特尔 Core Ultra NPU 和 Op

openlab_96bf3613

4月前

openlab_96bf3613

4月前

开放平台企业AI架构OPEA是一个开源项目,旨在帮助开发者构建开放、多提供商、稳健且可组合的生成式AI解决方案,充分利用生态系统中的最新创新技术。OPEA平台为开发者提供了生成式AI系统的模块化构建框架、包括LLM、数据存储和提示引擎等组件,以及端到端工作流的架构蓝图,简化了AI部署难度。 许多企业中的网络运行环境,由于安全和保密的需求,都是与公网Internet隔离的(air gapped)。在

openlab_96bf3613

4月前

openlab_96bf3613

4月前