OpenVINO™ 2025.3: 更多生成式 AI,释放无限可能

openlab_96bf3613

更新于 4月前

openlab_96bf3613

更新于 4月前

作者:武卓

介绍

在多种设备上高效运行 AI 模型,本该如此简单!

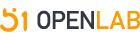

OpenVINO™ 是 Intel 推出的开源工具套件,专为开发者打造,让 AI 模型能够在 CPU、GPU 与 NPU 上实现极致优化与快速部署。全新 OpenVINO™ 2025.3 版本,为你带来更快的上手体验和更强大的性能。此次升级,重点聚焦 生成式 AI:新增多种前沿模型支持,推出全新 GenAI 流水线,并全面扩展了 OpenVINO™ 模型服务器的能力。

无论你想打造智能聊天机器人、领先的计算机视觉应用,还是突破性的生成式 AI 解决方案,OpenVINO™ 2025.3 都能为你提供简洁高效的工具,加速从灵感到落地的全过程,助力你的 AI 创意照进现实。

目录

1. 新增模型支持

2. OpenVINO™ GenAI 全面升级

3. OpenVINO™ 模型服务器增强

4. 总结展望

新增模型支持

在本次新版本中,我们新增了对更多生成式 AI 模型的支持,从大语言模型(LLM)到多模态视觉语言模型(VLM),包括 Phi-4-mini-reasoning、AFM-4.5B、Gemma-3-1B、Gemma-3-4B 和 Gemma-3-12B。你可以在 GitHub 上的 LLM Chatbot Notebook 中体验 Phi-4-mini-reasoning,这是一款针对高级数学推理能力进行微调的轻量级模型。同时,你还可以在 OpenVINO™ Notebooks GitHub 上快速上手更多模型,涵盖从多模态到音频再到计算机视觉等广泛应用场景。

NPU 支持在不断发展和扩展,为生产级工作负载提供低功耗的 AI 加速能力。本次版本中,新增了对 Qwen3-1.7B、Qwen3-4B 和 Qwen3-8B 等模型在 NPU 上的支持。NPU 能够持续应对生成式 AI 模型的高计算强度,同时具备更高的能效,使得 AI 部署更加易用且具备更高的性价比。为了帮助你更快在 NPU 上启动应用,我们在 ModelScope 上的 OpenVINO™专区中新增了一系列预转换和压缩后的 LLM 模型,可直接下载使用。

OpenVINO™ GenAI 全面升级

随着检索增强生成(RAG)在 AI 应用开发中持续发挥重要作用,我们正在通过 TextRerankPipeline 增强 OpenVINO™ GenAI 的 RAG 能力。在已有文本嵌入(text embedding)流水线支持的基础上,我们新增了文本重排序(text rerank)流水线,用于提升检索相关性并增强 RAG 流水线的准确性。现在,在你的 RAG 流水线中,经过文本嵌入检索之后,可以利用文本重排序流水线,根据查询内容的相关性对文本结果进行重新排序。

以下是 TextRerankPipeline 在 Python 中的使用示例:

import openvino_genaipipeline = openvino_genai.TextRerankPipeline(model_dir, "CPU")rerank_result = pipeline.rerank(query, texts)

AI 写代码

对于生成式 AI,我们也引入了对 结构化输出(Structured Output) 的支持。

这对那些希望将 AI 从对话式工具转变为可编程软件应用的开发者来说至关重要。软件需要可预测且可解析的数据格式,以便用于触发自动化操作、输入到其他 AI 系统,或支持更多高级应用场景。现在,OpenVINO™ GenAI 支持以结构化格式生成输出,例如 JSON、正则表达式(regex),或符合 EBNF(扩展巴科斯范式) 语法的结果。

下面的示例展示了如何使用 OpenVINO™ GenAI 为单一类型的对象(如 person)生成结构化的 JSON 输出。该示例使用 Pydantic schema 来定义生成结果的结构与约束条件。

import jsonfrom openvino_genai import LLMPipeline, GenerationConfig, StructuredOutputConfigfrom pydantic import BaseModel, Field# Define the schema for a personclass Person(BaseModel):name: str = Field(pattern=r"^[A-Z][a-z]{1,20}$")surname: str = Field(pattern=r"^[A-Z][a-z]{1,20}$")age: intcity: strpipe = LLMPipeline(models_path, "CPU")config = GenerationConfig()config.max_new_tokens = 100# If backend is not specified, it will use the default backend which is "xgrammar" for the moment.config.structured_output_config = StructuredOutputConfig(json_schema=json.dumps(Person.model_json_schema()), backend="xgrammar")# Generate structured outputresult = pipe.generate("Generate a JSON for a person.", config)print(json.loads(result))

这将生成一个符合 Person 架构的 JSON 对象,例如:

{"name": "John","surname": "Doe","age": 30,"city": "Dublin"}

了解更多关于这些全新的 OpenVINO™ GenAI 功能及其他内容,请访问我们的新文档页面:https://openvinotoolkit.github.io/openvino.genai/

OpenVINO™ 模型服务器

我们同样为 OpenVINO™ Model Server (OVMS) 带来了增强功能,这些改进也将惠及生成式 AI。

支持 GGUF 的 Hugging Face 模型现已提供预览支持,覆盖了多种主流大语言模型架构,例如 DeepSeek Distill、Qwen2、Qwen2.5 和 Llama 3。所谓 GGUF 模型,是指已转换并优化为 GGUF 文件格式的模型,该格式能够在保持原有模型能力的同时,大幅降低内存占用。这使得模型能够更高效地运行在 CPU 和低功耗设备上。

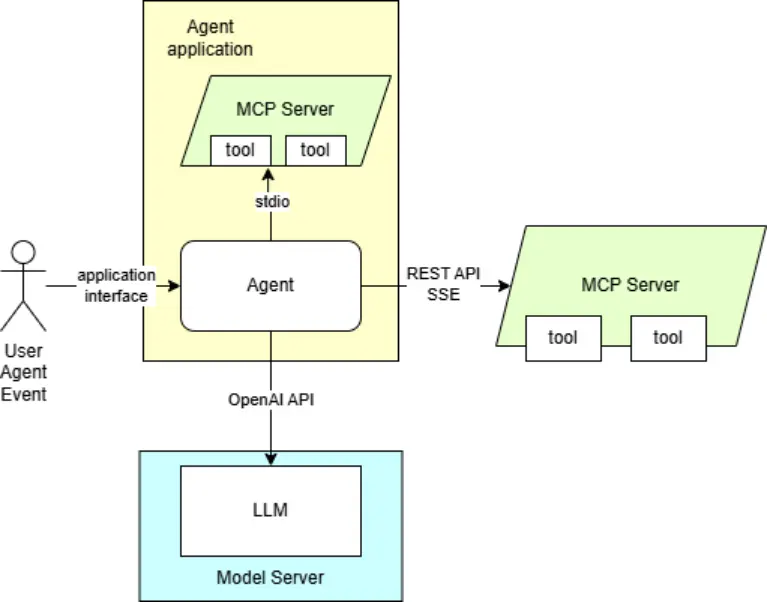

随着开发者越来越多地转向构建能够规划、执行任务和做出决策的 AI 系统,而不仅仅是对提示做出响应,Agentic AI 的热度正在迅速攀升。Agentic AI 的关键特性之一就是 工具调用(tool calling),它使模型能够连接外部工具和 API,从而获取超出原始训练数据范围的信息与能力。现在,OVMS 已可用于为 AI Agent 提供语言模型服务。它支持在内容生成场景中的工具调用,例如 图像生成、RAG(检索增强生成)以及聊天辅助,并且能够与 MCP 服务 及 AI agent 框架 集成。

立即查看演示,开始体验:使用 OpenVINO™ Model Server 的 Agentic AI。

Agentic AI 演示框图

总结

准备好让你的 AI 模型运行得更快了吗?立即下载 OpenVINO™ 2025.3 吧。

更多资源